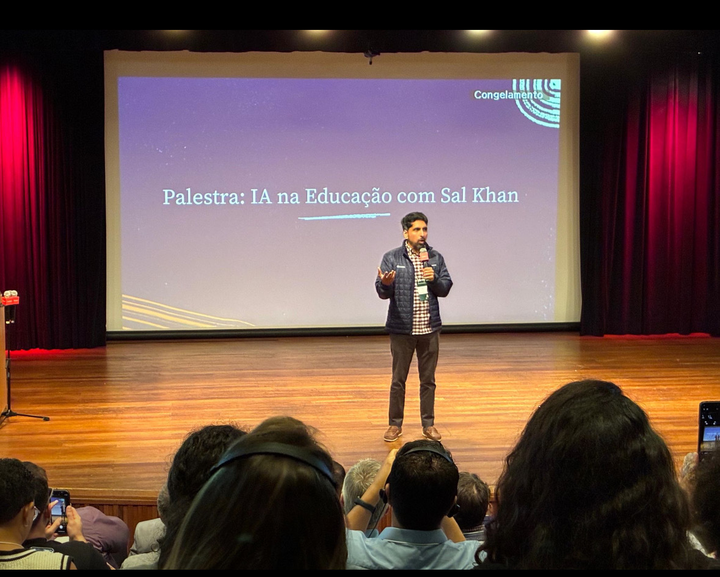

Nós da Khan Academy, uma organização educativa sem fins lucrativos, consideramos ser nossa responsabilidade explorar o que a IA pode significar para o futuro da educação.

Acreditamos que a Inteligência Artificial tem o potencial de transformar a aprendizagem de uma forma positiva, mas também estamos bem cientes dos riscos. Por esse motivo, desenvolvemos as seguintes diretrizes para o nosso desenvolvimento de IA.

Acreditamos que estas diretrizes nos ajudarão a adaptar responsavelmente a IA ao ambiente educativo. Queremos garantir que o nosso trabalho coloque sempre as necessidades dos alunos e dos professores em primeiro lugar.

E estamos empenhados em garantir que os benefícios da IA sejam compartilhados de forma igualitária em toda a sociedade. À medida que vamos aprendendo mais sobre a IA, estas diretrizes podem evoluir.

Nós educamos as pessoas sobre os riscos e somos transparentes em relação aos problemas conhecidos.

Estamos em um período de testes e convidamos um número limitado de pessoas a experimentar o nosso guia de aprendizagem baseado em IA.

Para o grupo de participantes que optou por utilizar as nossas ferramentas experimentais de IA, fornecemos uma comunicação clara sobre os riscos e as limitações da IA antes de lhes dar acesso.

Os participantes devem ler e aceitar os riscos e limitações conhecidos e potencialmente desconhecidos da IA. Por exemplo, a IA pode estar errada e gerar conteúdos inadequados. A IA pode cometer erros de matemática.

Proporcionamos aos participantes uma forma fácil de comunicar quaisquer problemas que encontrem.

Em termos mais gerais, estamos lançando o curso Inteligência Artificial e Khanmigo, disponível na área Khan para Educadores. No nosso curso, os utilizadores aprenderão:

- O que são modelos de linguagem de grande dimensão?

- Como é que os modelos linguísticos de grande dimensão se aplicam à educação?

- Em que a IA é boa?

- Em que a IA não é boa?

- Perguntas que todos nós deveríamos estar fazendo sobre a IA.

Aprendemos com as práticas recomendadas das principais organizações para avaliar e reduzir os riscos.

Estudamos e adaptamos estruturas do National Institute of Standards and Technology (NIST) e do Institute for Ethical AI in Education para avaliar e mitigar os riscos da IA específicos da Khan Academy.

A IA nem sempre é exata e não é totalmente segura. Reconhecemos que, neste momento, não é possível eliminar todos os riscos.

Por isso, trabalhamos diligentemente para identificar os riscos e implementar medidas de mitigação. Reduzimos os riscos através de abordagens técnicas, tais como:

- Alinhamento da IA para ajudar a aumentar a precisão;

- Engenharia imediata para orientar e restringir o foco da IA. Isto permite-nos treinar e adaptar a IA para um ambiente de aprendizagem;

- Monitorizar e moderar as interações dos participantes para que possamos responder prontamente os conteúdos inadequados e aplicar controles comunitários adequados (como a remoção do acesso);

- Testes para tentar deliberadamente ‘quebrar’ ou encontrar falhas na IA, a fim de descobrir potenciais vulnerabilidades;

Para além disso:

- A comunicação transmite que claramente haverá erros (mesmo em matemática) e a possibilidade de conteúdos inadequados.

- Limitamos o acesso à nossa IA através dos Khan Labs, um espaço para testar ferramentas de aprendizagem. Utilizamos critérios de seleção cuidadosamente para podermos testar as funcionalidades nos Khan Labs antes de abrangerem o acesso.

Acreditamos que estes esforços tornarão a nossa IA mais forte e mais confiável a longo prazo.

Neste momento, apenas concedemos acesso da nossa IA através do Khan Labs.

Para se inscreverem para testar o nosso guia de aprendizagem baseado na IA, os utilizadores devem ter pelo menos 18 anos de idade e registar-se através do Khan Labs. Uma vez registados, se os adultos tiverem filhos associados às suas contas da Khan Academy, podem conceder acesso aos seus filhos.

As nossas mensagens no produto indicam claramente as limitações e os riscos da IA. Limitamos a quantidade de interações que as pessoas podem ter com a IA por dia, porque observamos que as interações prolongadas têm maior probabilidade de conduzir a um mau comportamento da IA.

Todas as crianças que têm o consentimento dos pais para utilizar o nosso guia de aprendizagem com IA, recebem uma comunicação clara de que o seu histórico de conversação e atividades são visíveis para os pais ou tutores e, se aplicável, para o professor.

Os professores podem ver os históricos de conversação dos seus alunos. Utilizamos tecnologia de moderação para detectar interações que possam ser inadequadas, prejudiciais ou inseguras. Quando o sistema de moderação é acionado, envia um alerta automático por correio eletrônico a um adulto.

Adotamos e incentivamos uma cultura em que a ética e o desenvolvimento responsável estão integrados nos nossos fluxos de trabalho e mentalidades.

Os indivíduos e as equipes são convidados a identificar considerações éticas e a avaliar os riscos no início de cada projeto. A nossa tomada de decisões é orientada pela avaliação dos riscos. Damos prioridade à atenuação dos riscos, abraçamos a transparência e refletimos continuamente sobre o impacto do nosso trabalho.

Temos um plano detalhado de monitorização e avaliação em vigor durante este período de testes. Iremos aprender, interagir e melhorar.

A IA é uma tecnologia emergente que está se desenvolvendo rapidamente. Estamos entusiasmados com seu potencial para beneficiar a educação e reconhecemos que temos muito a aprender.

O nosso objetivo final é aproveitar o poder da IA para acelerar a aprendizagem. Avaliaremos o funcionamento da IA e partilharemos os nossos conhecimentos com o mundo. Esperamos adaptar os nossos planos ao longo do caminho.